对网络安全领域而言,AI市场热潮与前景伴随着担忧与风险。以下是需要重点关注的事项。

- Gartner client? Log in for personalized search results.

网络安全中的AI: 明确战略方向

CISO与CIO:在管控关键风险的同时最大化实现AI价值

随着AI热潮持续重塑网络安全格局,企业面临着新的机遇和挑战。AI拥有颠覆安全实践的潜力,但其发展道路充满了风险和不确定性。

立即下载Gartner 最新发布的电子书,以帮助您:

- 将AI的影响力与企业成熟度相匹配

- 聚焦关键风险领域,如数据隐私问题及新兴威胁等

- 将AI融入现有网络安全策略,以实现最大效益和相关成果

AI对网络安全与CISO的影响

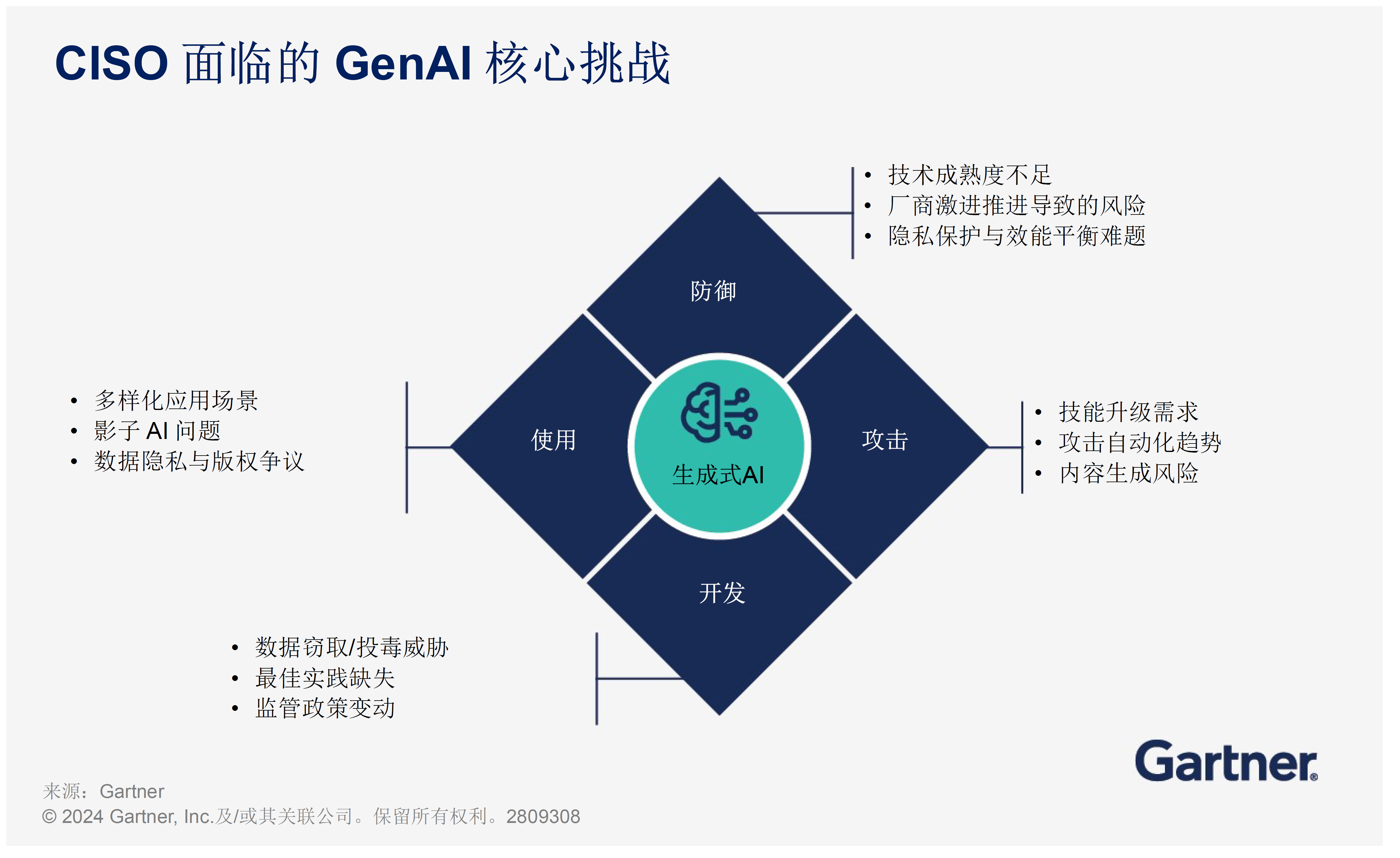

要有效应对AI在网络安全领域带来的变革,CISO 需深入理解相关技术热潮、风险及应用潜力。

网络安全领域的AI热潮

AI带来的网络安全风险

AI 在网络安全中的潜力

理性看待人工智能市场预期

GenAI的早期热潮令许多企业心动不已,在缺乏充分规划的情况下仓促上马。然而,这种短视投入存在高风险,因为现实回报往往难以匹配市场预期。

通常,企业经历数月的试验与调整后,然后进行追溯评估、财务核销。甚至在部分情况下,因投资失败导致高管离职(具体取决于核销规模)。更严重的影响在于,生成能力的延迟部署可能造成不可逆的市场机会损失。

在短期内,外界对安全运营效率提升的压力,与 GenAI技能不成熟及工作流程碎片化的现实相冲突,必然会引发市场幻灭期。

警惕GenAI整合准备不充分的典型表现:

过度聚焦“生产力提升”指标,忽视实际业务收益,且GenAI附加功能总拥有成本高企

AI辅助工具难以深度集成到安全运营团队与托管安全服务提供商的工作流

“提示疲劳”——多工具并行查询威胁与事件,导致交互冗余

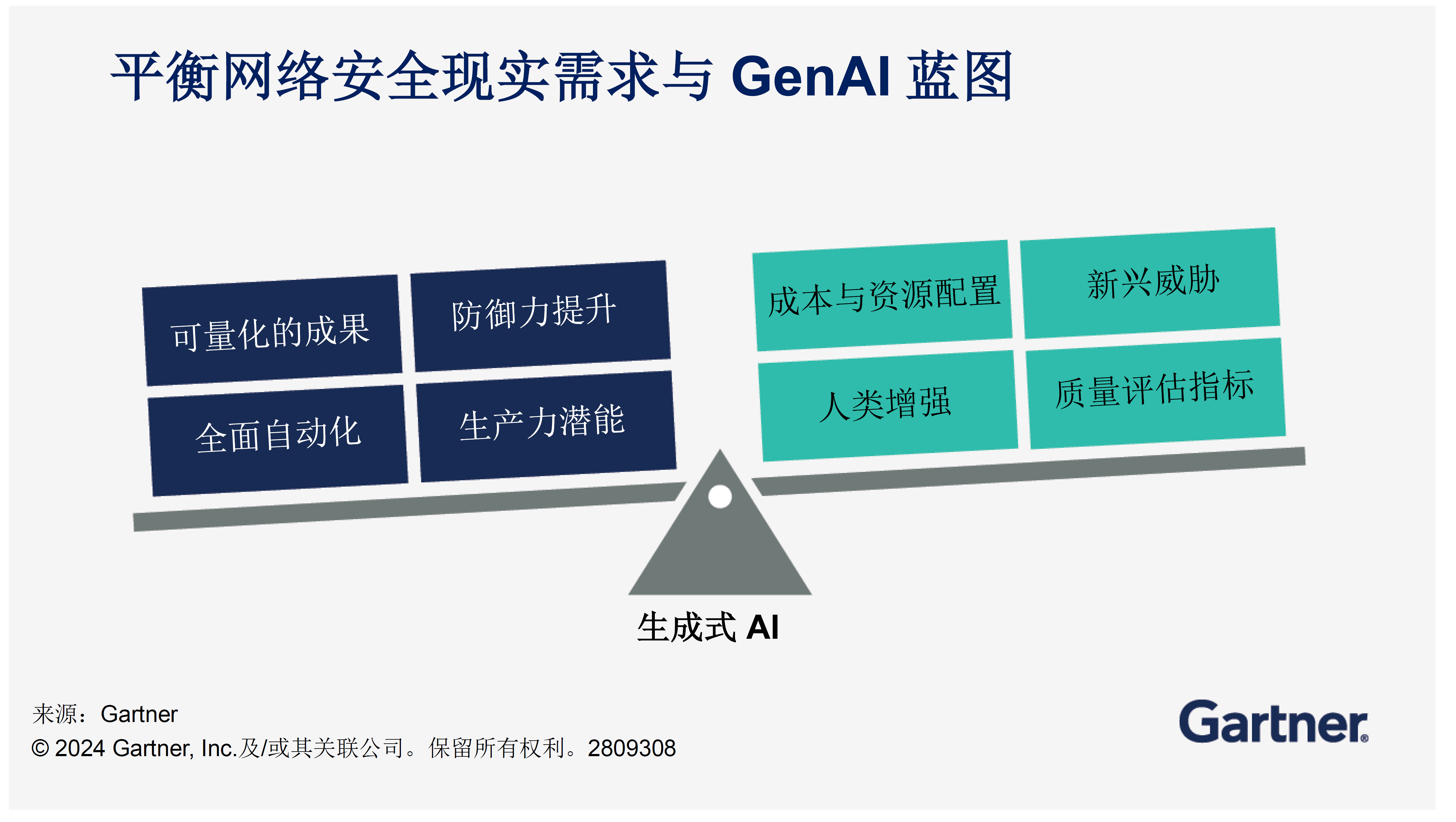

为消除AI过度宣传带来的预期偏差,CISO需制定实施路线图,充分考量各类因素,在网络安全现实需求与实现GenAI潜力之间寻求平衡:

- 采取多年期渐进部署计划。从应用安全和安全运营开始,逐步整合可增强安全工作流的GenAI功能。

- 充分考量“是否值得?”设定投资期望并衡量自身能力。评估效率增益与成本增量。根据GenAI网络安全功能优化检测和生产力指标。

- 优先考虑利用AI增强员工能力(而不仅是任务自动化)。规划GenAI带来的长期技能需求变化。

解决隐私挑战,在提升安全能力的预期收益与 GenAI风险管控之间保持平衡。

构筑最优防御体系

GenAI是众多旨在通过任务自动化提升生产力的技术之一。然而,过去尝试将复杂安全活动完全自动化的案例鲜有成功,反而可能分散注意力,造成资源浪费。

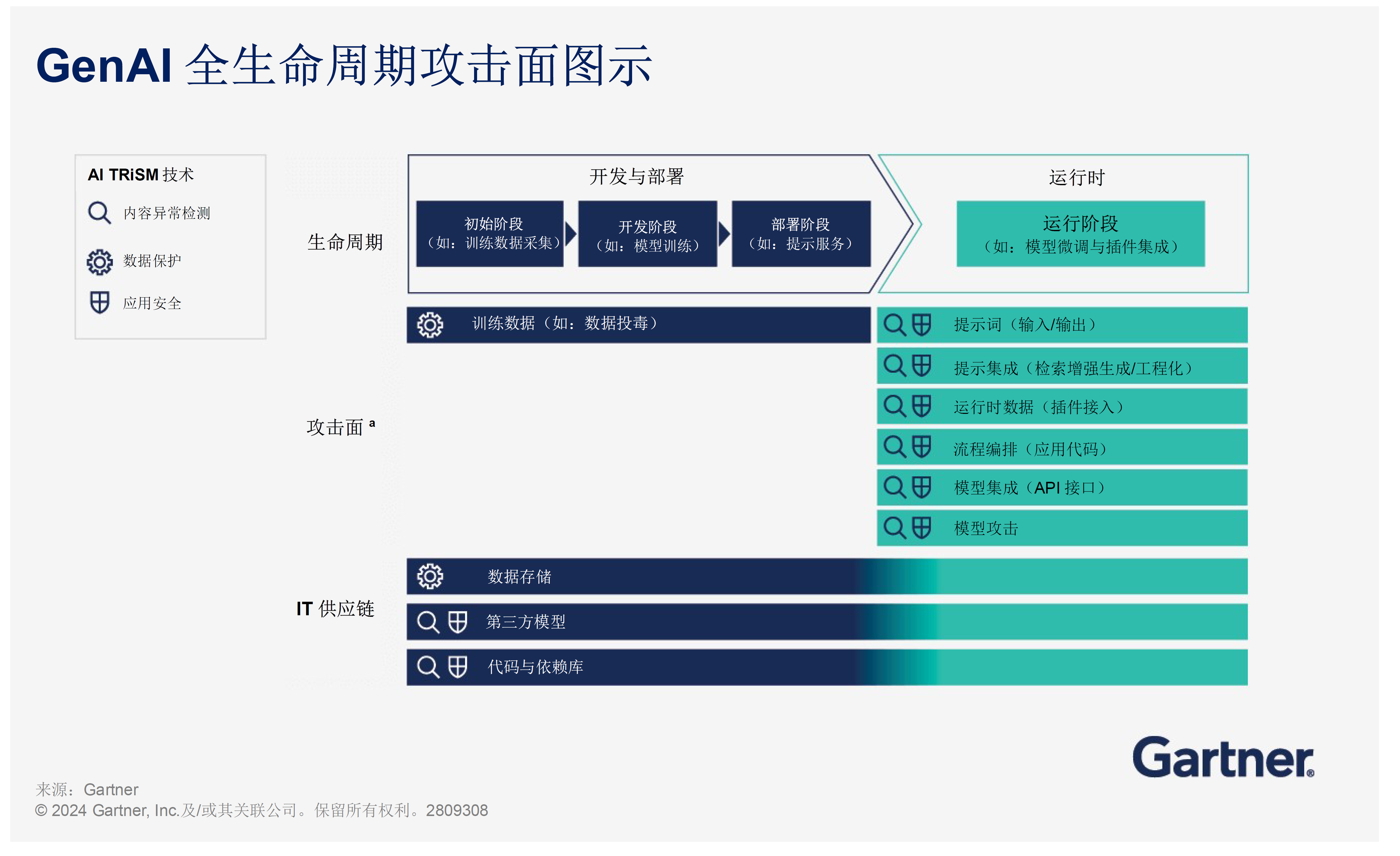

尽管GenAI模型及第三方大语言模型(LLM)带来了诸多优势,但也引入了前所未有的用户风险,要求企业调整安全实践。相关风险大致可分为三类:

内容异常检测

产生幻觉性输出、事实性错误、违规或侵权内容以及其他不当内容,可能导致决策偏差并引发品牌声誉危机

不当或恶意使用

通过提示注入未受管控的企业内容,导致机密数据泄露

数据保护

托管供应商环境的数据泄露风险可能导致内容完整性受损,并威胁用户数据的机密性。

外部托管环境存在治理挑战,难以有效管理隐私及数据保护政策

由于第三方模型的“黑箱”特性,难以进行隐私影响评估并满足地域性合规要求

原始数据一旦被吸收,除非重建模型(成本极高且不切实际),否则无法彻底擦除

AI应用安全

对抗性提示攻击:包括业务逻辑滥用,以及直接或间接的提示注入攻击。

向量数据库攻击

模型状态与参数泄露

外部托管的LLM及其他GenAI模型加剧了这些风险,因为企业难以直接控制模型的应用流程、数据处理及存储方式。然而,即便是企业自托管的本地模型,若缺乏充分的安全与风险控制,同样存在隐患。在AI应用及模型运行期间,这三类安全风险始终是企业需要重点防范的威胁。

选择AI增强模式

讽刺的是,使GenAI备受瞩目的对话界面,反而成为其在企业内部落地失败风险上升的主要因素。主要挑战体现在以下两个方面:

使用率与投资回报率(ROI)。GenAI的ROI取决于员工的使用情况及技术带来的实际收益。然而,员工并不一定主动采用对话界面。如果缺乏明确的价值主张,GenAI将难以融入日常工作流程。此外,GenAI对业务的实际贡献则难以量化,企业往往只能跟踪使用频率,而实际使用情况只有用户知晓。

提示与幻觉。不同用户以不同方式提出相同问题,可能会得到截然不同的答案。提示的质量直接影响回答的准确性,而AI生成的答案可能存在幻觉。企业应通过提示工程培训提升员工的提问能力,并在用户遇到错误答案时提供支持。此外,还需投资提示预处理和响应后处理机制,以减少幻觉现象,提高生成内容可靠性。

为应对以上问题,可监控安全从业人员在特定任务中的实际操作,预先构建标准化提示,降低用户对自由对话输入的依赖。

使用生成式增强工具(GAs):生成式增强工具(GAs)是一种在主应用程序上构建的插件或扩展,用于实时监控用户行为。GAs结合观察到的数据、来自其他系统的输入以及预编程的提示,帮助用户提高任务执行效率。这些提示会与大模型交互,并以预定格式接收响应,从而有效缓解幻觉问题。通过增强逻辑对每个响应进行严格验证,确保其准确性和相关性后,方才将结果反馈给用户。这些增强工具不依赖传统的对话/聊天界面(UI)。

关于网络安全与AI的常见问题

什么是网络安全+AI?

网络安全+AI是指利用人工智能技术提升计算机系统、网络和数据的安全性,防范潜在的威胁和攻击。通过AI,系统能够实时分析海量数据,识别复杂模式,检测异常行为,并快速做出智能决策,从而增强网络威胁的预防、检测与响应能力。

AI如何颠覆或变革网络安全领域?

通过增强威胁检测能力、自动化安全操作、优化用户身份验证,以及提供高级分析功能,AI正在网络安全领域创造深刻变革。

将AI集成到现有网络安全基础设施中的主要考量因素

在将AI整合进现有网络安全架构时,需重点关注以下几个关键要素:

- 数据的可用性与质量

- 兼容性与集成性

- 可扩展性与性能

- 可解释性和透明度

- 人机协作

- 伦理与法律考量

- 培训与技能发展

- 供应商选择与专业能力

- 风险评估与缓解措施